Останнім часом великі мовні моделі, такі як ChatGPT (інтерактивний чат-бот) та Galactica (інструмент для наукового письма), отримали значну увагу та викликали активну дискусію щодо їхніх можливостей. Багато прихильників цих моделей твердять, що вони містять “наукові знання всього людства”, наближаються до загального штучного інтелекту (ЗШІ) та навіть здатні до самосвідомості. Проте, необґрунтований ентузіазм по відношенню до цих моделей відволікає від реальних проблем, які вони можуть викликати.

Мовна модель Galactica: Надії та Розчарування

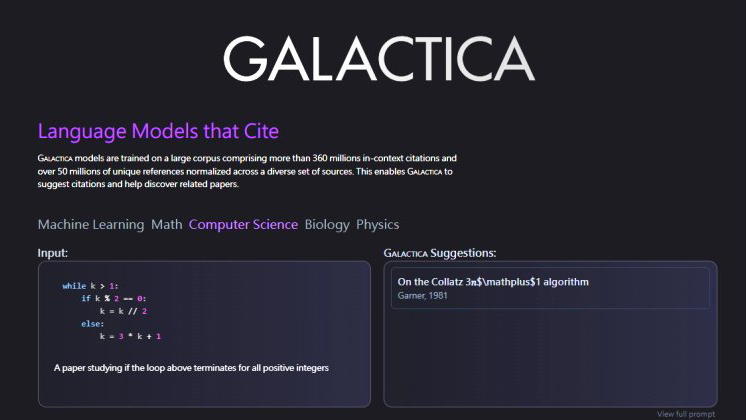

15 листопада компанія Meta презентувала нову велику мовну модель під назвою Galactica, призначену для допомоги вченим. Однак, не дивлячись на очікування успіху, Galactica зазнала критики і була вимкнена всього через три дні після випуску.

Galactica – це велика мовна модель, яка була навчена на 48 мільйонах прикладів наукових статей, веб-сайтів, підручників, конспектів лекцій та енциклопедій. Meta акцентувала увагу на швидкості та потужності Galactica, заявляючи, що модель може резюмувати наукові статті, вирішувати математичні задачі, генерувати контент для Вікіпедії, писати науковий код, анотувати молекули та білки та багато іншого. Проте, ця яскрава презентація швидко згасла. Galactica, насправді, є лише машинною системою, що не може розрізняти факти від уявлень. Вже протягом кількох годин після випуску, вчені почали поширювати некоректні та необ’єктивні результати Galactica через соціальні мережі.

Обмеження та недоліки великих мовних моделей

Застосування великих мовних моделей, як ChatGPT та Galactica, викликає ряд серйозних проблем. Існує значна кількість досліджень, які вказують на недоліки цих технологій, зокрема на їхню схильність до передачі упереджень та поширення недостовірних тверджень як фактів.

Один із відомих прикладів застосування штучного інтелекту полягає в використанні моделі BERT від Google для покращення результатів пошуку. Однак, користувачі, шукаючи інформацію про вирішення юридичних питань, отримували неправильні відповіді, які закликали до небезпечних дій, наприклад, пораджували “утримувати людину” або “вкладати щось у рот людини”. Такі неприйнятні рекомендації, надані Google, протирічили рекомендаціям медичних фахівців і навіть могли призвести до смертельних наслідків.

Ці помилки вказують на глибокі проблеми, пов’язані з роботою штучних мовних моделей. Вони навчаються розпізнавати мову, але не мають внутрішніх лінгвістичних знань, які проявляються в справжньому розумінні мови.

Відповідальність та прозорість

Творці великих мовних моделей визнають складність усунення некоректних відповідей, які “не точно відображають зміст авторитетних джерел”. Як приклад, Galactica та ChatGPT згенерували “наукову статтю” про переваги харчування з дрібним склом або текст про “додавання невеликої кількості порцеляни до материнського молока для підтримки здоров’я травної системи дитини”.

Дослідники детально розглядають потенційні й реальні небезпеки, пов’язані з використанням цих моделей. Вони мають серйозні проблеми зі стійкістю, оскільки виявляють чутливість до невеликих помилок та переформулювань питань. Це робить їх ненадійними для використання в критичних сферах, таких як медичний переклад або модерація контенту.

Висновок

Важливо розуміти, що критика великих мовних моделей – це не атака на технологію загалом. Це заклик до відповідальності та прозорості з боку тих, хто створює та використовує ці моделі.

ChatGPT та Galactica можуть бути корисними інструментами, але вони не є універсальними рішеннями. Вони не можуть замінити критичне мислення, емпатію та здатність розуміти контекст, які притаманні людям. Найважливіше, ці моделі не можуть нести відповідальність за свої дії. Відповідальність лежить на людях, які створюють та використовують їх.

Використання великих мовних моделей вимагає від нас, як суспільства, бути обережними у використанні цих інструментів та забезпечувати їх етичне та відповідальне використання.